Der HDR-Standard und was er bringt

Bei der Vermarktung von Fernsehern wird mit vielen Abkürzungen gearbeitet. Einige davon entsprechen offiziellen Standards, andere sind herstellerspezifische Bezeichnungen. Oft fragt man sich dann: Was bedeutet diese Abkürzung eigentlich ganz genau? Was bringt mir dies oder brauche ich das überhaupt? In diesem Artikel beantworten wir diese und weitere Fragen rund um HDR.

Was bedeutet HDR?

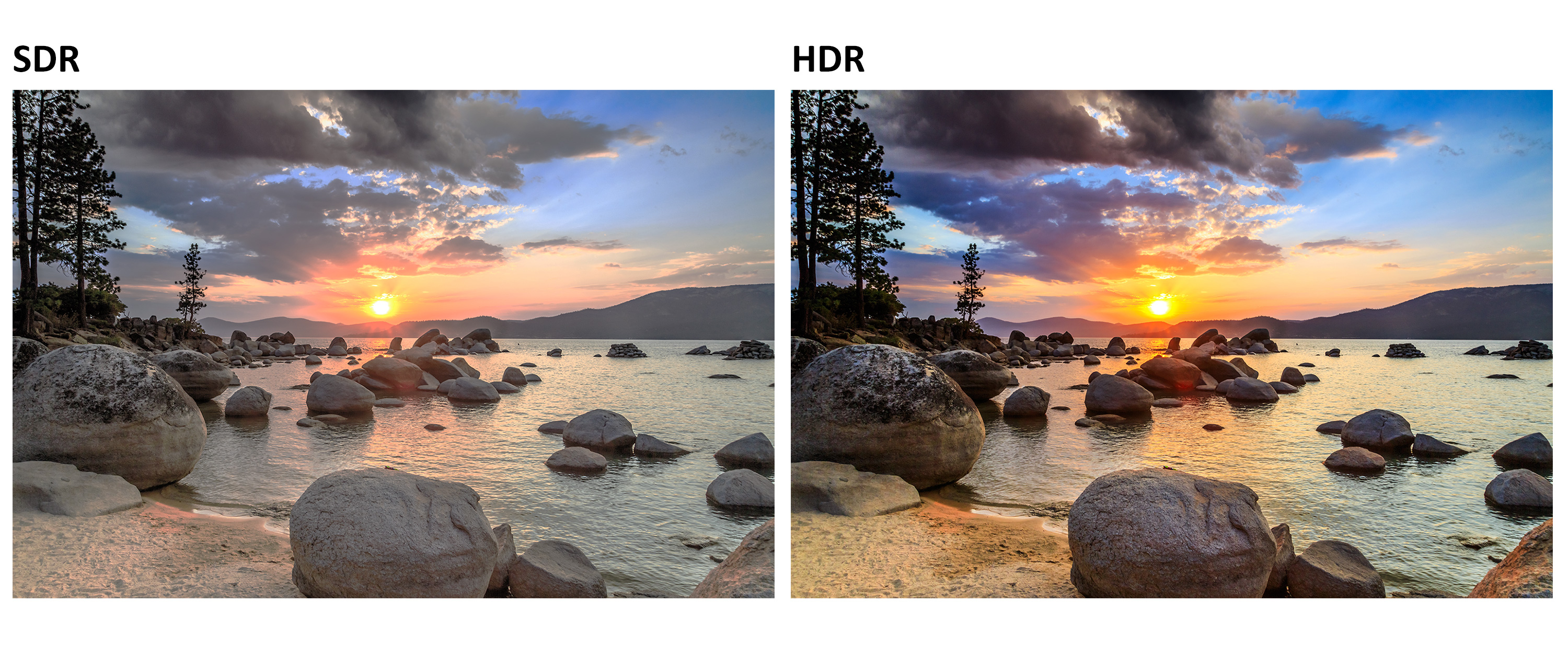

Bei HDR handelt es sich um einen Bildstandard, der parallel zur Einführung von 4K- oder gar 8K-Fernsehern einen der wichtigsten Technologiesprünge der letzten Jahre darstellt. HDR ist die Abkürzung für «High Dynamic Range», was in Deutsch «hoher Dynamikumfang» bedeutet. Dies bezieht sich auf die Qualität der abgespielten Bildquelle und wie ein Bildschirm oder Fernseher diese darstellen kann. Die wichtigsten Faktoren dabei sind der Kontrast zwischen hell und dunkel sowie die Anzahl darstellbarer Farben.

HDR ist nicht zu verwechseln mit «HD» (High Definition): Während sich HD auf die Auflösung des Bildes bezieht, also wie viele Bildpunkte dargestellt werden können, beschreibt HDR wie lebendig und realitätsgetreu die Farben im Bild daherkommen.

Die historische Entwicklung: Von SDR zu HDR

Ältere Bildquellen nutzen oft noch den SDR-Standard (Standard Dynamic Range), welcher noch aus der Ära der Röhrenbildschirme stammt und vor über 30 Jahren definiert wurde. SDR nutzt eine 8-Bit Farbtiefe, womit die Darstellung von 16,77 Millionen Farbabstufungen ermöglicht wird. HDR dagegen bringt es dank 10 Bit auf über eine Milliarde Farbtöne. Wenn man von diesen kräftigen Farben und nuancierten Abstufungen der HDR-Technologie profitieren will, müssen sowohl die Quelle (Blu-ray Player, Blu-ray, Spielkonsole, TV-Kanal) als auch der Fernseher dem HDR-Standard entsprechen und mit diesem umgehen können. Dies ist bei allen gängigen Geräten heute die Regel. Haben Sie noch ein älteres Gerät ohne HDR-Standard, keine Sorge: SDR wird weiterhin problemlos auf jedem Fernseher dargestellt.

Was ist ein Bit?

Die Anzeige von Flachbildschirmen ist in Hunderttausende bis mehrere Millionen Bildpunkte (Pixel) aufgeteilt. Jeder Pixel besteht aus drei Sub-Pixeln (Rot, Grün, Blau), die unterschiedlich hell leuchten können. So entstehen die Farben.

Der Bit-Wert gibt an, wie viele Farben ein Monitor anzeigen kann. Das errechnet sich daraus, wie viele Helligkeitsstufen die Subpixel beherrschen und aus wie vielen Subpixeln ein Pixel besteht.

Formel: Anzahl Farben = 2(Bit-Wert x Anzahl Subpixel)

Bei einem 8-Bit-Display sind es 28, also 256 Helligkeitsstufen pro Subpixel. Und da es pro Pixel drei Subpixel hat und jeder der drei Subpixel eine andere Helligkeit haben kann, ergibt sich eine Gesamtzahl von 256 x 256 x 256, also 2563 Farben, die ein Pixel darstellen kann – also 16.7 Millionen Farben. Bei einem 10-Bit-Display wären es 2(10*3), also 1.07 Milliarden Farben.

HDR ist nicht gleich HDR – die verschiedenen Varianten von HDR

In der Praxis begegnet man heute verschiedenen HDR-Bezeichnungen, von HDR10 über HDR10+ oder Dolby Vision bis hin zu HDR1000. Also doch kein Standard? Leider wird der Begriff HDR heute sehr inflationär genutzt und je nach Hersteller kommen unterschiedliche Erweiterungen des Basis-Standards «HDR10» zum Einsatz. Daher nachfolgend eine Übersicht über die verschiedenen Varianten von HDR und was sich jeweils genau hinter den jeweiligen Begriffen und Abkürzungen verbirgt.

Hersteller-unabhängige HDR-Technologien

HDR10 | HDR10 ist der Basisstandard für «High Dynamic Range». Er ist lizenzfrei und daher weit verbreitet im Markt. HDR10 steht für HDR mit 10 Bit Farbtiefe und liefert so 1024 Helligkeitsstufen. Bei HDR10 werden Daten zur Farbdarstellung jeweils für den ganzen Inhalt an den Fernseher übertragen. Die Einstellungen sind somit statisch und werden nicht individuell Bild für Bild angepasst. HDR10 kann so in Bezug auf die Helligkeitsabstufungen oder die Dynamik nicht mit den nachfolgenden, weiterentwickelten HDR-Systemen mithalten. Dafür wird es von fast allen Content-Anbietern und Medien unterstützt, z.B. Netflix, Amazon Prime, Blu-ray, etc. Tipp: Ein TV, der nur mit HDR10 umgehen kann, ist heute nur noch dann sinnvoll, wenn das Budget beim Kauf die oberste Priorität hat. |

HDR10+ | HDR10+ ist eine lizenzfreie Technologie und ebenfalls weit verbreitet. Sie wurde von Samsung und Amazon als Alternative zu Dolby Vision entwickelt und hat den Vorteil, dynamische Parameter an den TV zu übermitteln. Auf Basis dieser Metadaten werden für jedes Einzelbild lebensechte Farben und ausgeprägte Details errechnet. HDR10+ ist auch zu SDR-Geräten abwärtskompatibel, obwohl die Detailfülle dann natürlich nur in einem beschränkten Rahmen dargestellt werden kann. |

Dolby Vision | Um einen noch höheren Standard bieten zu können, entwickelte die Firma Dolby Labs im Jahr 2015 die Technologie «Dolby Vision». Sie basiert auf 12bit und kann daher 4-Mal so viele Helligkeitsstufen darstellen wie der Basis-Standard HDR10. Auf TVs, welche Dolby Vision einsetzen, können so bis zu 68 Milliarden Farbtöne dargestellt werden. Dolby Vision ist aber lizenzpflichtig und daher weniger stark verbreitet als freie HDR-Technologien. Dolby Vision-Inhalte findet man z.B. auf Netflix. LG setzt bei seinen OLED-Modellen auf dieses Format. Da Dolby Vision dynamische Daten liefert, ist es mit allen SDR- und HDR-Geräten kompatibel, kann aber natürlich nur in voller Pracht zur Geltung kommen, wenn sowohl die Bildquelle als auch der Bildschirm Dolby Vision nutzen. |

Dolby Vision IQ | Auf der CES 2020 wurde eine weitere Verbesserung der Bilddarstellung in Form von «Dolby Vision IQ» vorgestellt. Durch Nutzung des Umgebungslichtsensors eines Fernsehers passt Dolby Vision IQ die Darstellung automatisch den herrschenden Lichtverhältnissen an und erreicht so eine bestmögliche HDR-Bildwiedergabe. |

HLG | Hybrid-Log-Gamma (HLG) ermöglicht es, HDR-Qualität auch auf ältere TVs zu bringen. Es ist ein lizenzfreies HDR-Format, welches vor allem für die Ausstrahlung von Kabel- oder Satelliten-TV-Programmen genutzt wird. So werden im Rahmen des Möglichen auch auf älteren Fernsehern realitätsnähere Bildresultate erzielt. |

HDR400 | HDR400 bezieht sich primär auf die maximale Leuchtdichte eines Fernsehers. Ein HDR400-TV muss eine Spitzenleistung von mindestens 400 cd/m2 schaffen und ein konstantes Minimum von 320 cd/m2 erreichen. Da die Helligkeit im Bildschirm stärker variiert werden kann, wird so eine bessere Detaildarstellung erzielt. Diese Bezeichnung wird vor allem von Computermonitor-Herstellern genutzt, um sich gegenüber Displays nach SDR-Standard abzugrenzen. |

HDR600 | Für HDR600 muss die maximale Leuchtdichte 600 cd/m² betragen, die minimale dauerhafte Leuchtdichte liegt jedoch bei nur 350 cd/m² und ist damit nur 30 cd/m² höher als bei einem Gerät mit HDR400. Hier kommen aber laufend weitere Abstufungen hinzu, auch diese werden primär im Computermonitor-Umfeld genutzt: Aktuell HDR1400 oder True Black 600, wo zusätzlich festgelegt wird, welche Helligkeit schwarze Bildbereiche maximal aufweisen dürfen (z.B. bei True Black 600 max. 0,0005 cd/m2). |

Demo-Video zu HDR10 auf YouTube ansehen:

Achtung: Um zu sehen, ob dieses Video wirklich in HDR dargestellt wird, machen Sie einen Rechtsklick auf dem Video und wählen Sie «Statistik für Interessierte» aus. Wird unter «Color» bt2020 angezeigt, wird das Video auch wirklich in HDR angezeigt. Sonst erscheint dort der Wert bt709 und das Video wird nur auf SDR umgerechnet dargestellt.

Proprietäre HDR-Technologien

Neben den HDR-Standards, welche von vielen unterschiedlichen Brands eingesetzt werden, gibt es auch HDR-Bezeichnungen, die nur von einzelnen Herstellern entwickelt und genutzt werden.

HDR 10 Pro | HDR 10 Pro darf nicht mit HDR10+ verwechselt werden. Es handelt sich nicht um einen offiziellen Standard, sondern um einen Bildalgorithmus, welcher das HDR10-Bildergebnis auf LG-Geräten zusätzlich verbessert. |

HDR Pro | HDR Pro bezeichnet eine Technologie, welche bei BenQ-Beamern zum Einsatz kommt. Dieser Standard ist spezifisch an die Bedürfnisse von Projektoren angepasst und sorgt per Algorithmus für eine realitätsgetreuere Bilddarstellung. |

HDR1000 | HDR1000 wurde von Samsung entwickelt, um mit einer maximalen Leuchtdichte von 1000 cd/m2 (mind. 600 cd/m²) noch mehr Helligkeitsstufen abdecken zu können. Dadurch steigt der Detailgrad der Bilder noch einmal deutlich: Weiss wird noch weisser resp. Schwarz noch schwärzer dargestellt. |

Q HDR 1500 bis 4000 | Auch bei Q HDR (Quantum HDR) handelt es sich um eine Weiterentwicklung von Samsung, welche auf QLED-Geräten noch höhere Detailgrade ermöglicht. Wie die Bezeichnung jeweils impliziert, mit Spitzenhelligkeiten von 1500, 2000 oder gar 4000 cd/m2. |

HLG Pro | LG setzt auf seinen Geräten die Variante HLG Pro ein, welche die HLG-Bildinhalte durch einen internen Algorithmus zusätzlich verbessert. Ähnlich wie bei HDR 10 Pro wird der Videoinhalt zusätzlich rechnerisch aufpoliert. |

Fazit

Dank HDR können heute Filme und TV-Programme in nie dagewesenem Detailreichtum und bisher unerreichter Farbtreue erlebt werden. HDR ist neben gesteigerter Auflösung in Form von mehr Bildpunkten (Full-HD, 4K, 8K) einer der wichtigsten technologischen Fortschritte im TV-Markt der letzten Jahre. Da die heimischen Flachbild-TVs immer grösser werden, ist vor allem der gesteigerte Detailgrad in der Bilddarstellung höchst willkommen und erlaubt ein immer realitätsnäheres Fernseh-Erlebnis.

Ratgeber TV & Heimkino

Zurück zur HauptseiteKommentare (0)

Bitte melden Sie sich an, um die Kommentarfunktion zu nutzen.