Comparaison des processeurs: pourquoi le nombre de gigahertz ne veut rien dire

La performance des processeurs des ordinateurs de bureau ou portables n’est plus conditionnée à leur nombre de gigahertz. Nous vous indiquons les composants qui déterminent aujourd’hui de manière significative la performance d’un processeur.

S’intéresser à la genèse de certaines histoires peut se révéler aussi passionnant que l’histoire elle-même. Le duel que se livrent depuis presque toujours AMD et Intel, les deux grands fabricants de processeurs, en est un exemple parfait.

AMD et Intel: l’éternel duel

Jusqu’en 1998, tout se passait bien dans le monde d’Intel. La série de processeurs phare de l’époque, les «Pentium» équipait huit PC sur dix à travers le monde. Dans la compétition des PC de milieu et de haut de gamme, AMD est resté pratiquement tout ce temps sur le banc de touche, ne marquant des points qu’au niveau du prix.

L’année 1999 a marqué un tournant pour AMD grâce au nouveau processeur «Athlon». Voilà qu’apparaissait subitement un processeur qui, du point de vue des performances, éclipsait son concurrent Intel, pourtant très puissant. La surprise fut générale: AMD était une petite entreprise dont le chiffre d’affaires annuel correspondait plus ou moins à la somme qu’Intel devait dépenser en impôts. Cette entreprise venait de développer un processeur qui surpassait le Pentium. Pourquoi? À l’époque, la stratégie appliquée au Pentium consistait à ne cesser d’augmenter la vitesse d’horloge, ce qui avait ses limites. Résultat: le processeur a connu d’énormes problèmes de chauffe et une baisse de ses performances. Il était obligé de ralentir sa fréquence d’horloge pour éviter la fonte de ses circuits (throttling). Conséquence: AMD a grignoté peu à peu les parts de marché d’Intel, en tout cas jusqu’en 2006.

La microarchitecture Core marque un tournant

Mais, finalement, Intel a su faire volte-face en 2006 avec l’aide de son laboratoire de recherche israélien. Le processeur pour ordinateur de bureau «Core 2 Duo» en sortit et s’opposa alors à l’Athlon 64 FX-62, ce qui permit à Intel de se remettre en lice. La «microarchitecture Core» a marqué un tournant dans l’histoire des processeurs. Tout à coup, la fréquence du processeur en gigahertz n’était plus aussi décisive, mais sa performance, répartie notamment sur plusieurs cœurs parallèles économes (en énergie) au sein du processeur principal. Intel décide à l’époque que les processeurs d’ordinateurs de bureau et de portables, les duos Core 2 et les générations suivantes, voire les serveurs, proviendraient d’une seule et même ligne de production, mais seraient optimisés pour chaque catégorie d’appareils. Cette décision a accéléré la fabrication du processeur et également simplifié sa conception.

C’était au tour d’AMD d’être inquiété. Il a fallu attendre 2017 pour qu’AMD puisse enfin faire le poids (ill. 1). Cette année-là, le fabricant lance la nouvelle architecture de processeur «Zen/Zen+» sous le nom de marque Ryzen (prononcé «Raïzen»), un défi lancé à Intel. Depuis, le coude à coude entre AMD et Intel reste serré. Jusqu’à maintenant, tous deux se disputent à tour de rôle la position de leader selon la nouvelle ligne de processeurs «Ryzen» ou «Core-i» qu’ils présentent.

Si l’on observe les changements intervenus dans l’architecture des processeurs entre hier et aujourd’hui, on constate qu’elle est passée d’une structure à un seul cœur assez simple, avec des fréquences d’horloge toujours plus élevées, à une structure où les puces sont dotées de plusieurs unités de calcul parallèles et économes en énergie. En outre, les pistes conductrices se sont étrécies et affinées (elles sont désormais de l’ordre du nanomètre, sachant qu’1 nanomètre = 1*10-9 mètres) rendant la structure générale bien plus complexe. Cette complexité est le troisième élément permettant de classer la performance globale d’un processeur, hormis sa fréquence et ses unités de calcul parallèles.

Pourquoi la simple fréquence d’horloge ne veut rien dire

Se focaliser sur la seule fréquence du processeur pour connaître sa puissance ne lui rend pas justice. Voici un exemple éloquent: les processeurs modernes, qu’ils soient d’AMD ou d’Intel, sont désormais à même de faire varier leur fréquence d’horloge en fonction de l’application utilisée. La logique au sein du processeur reconnaît les exigences de traitement des instructions que lui impose l’application ou le jeu vidéo en cours.

En principe, le processeur dispose aujourd’hui de deux voies pour traiter les instructions le plus rapidement possible. Il peut soit ajouter plusieurs cœurs afin d’accélérer le traitement parallèle des données, soit réduire le nombre de cœurs à utiliser, quitte à n’en prendre qu’un seul. Dans ce cas, il n’est pas nécessaire d’ajouter des cœurs pour effectuer la tâche. En revanche, il est possible d’augmenter la fréquence d’horloge de l’un des cœurs, au profit de la vitesse d’exécution.

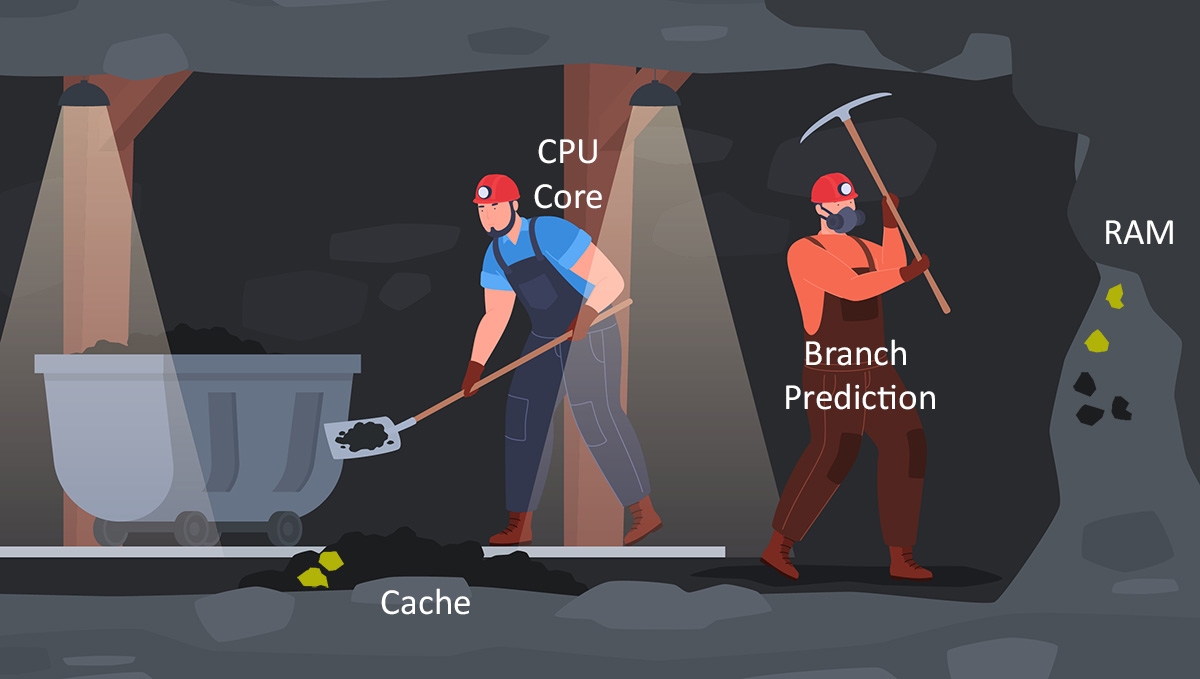

Pour imaginer cela, comparons le fonctionnement du processeur au travail d’un employé des mines (ill. 2): un mineur envoie des pelletées de charbon dans un chariot. Le mineur correspond à un noyau de processeur, le charbon aux données ou aux instructions à traiter. La fréquence d’horloge n’est rien d’autre que la cadence, soit la vitesse à laquelle le mineur envoie ses pelletées dans le chariot. Dans cet exemple, le chariot correspond aux pistes conductrices qui transportent les données. Le nombre de cœurs du processeur pourrait être assimilé au nombre de travailleurs.

Si le mineur remplit plus rapidement le chariot (nombre de GHz important), c’est le rendement (données en sortie) qui augmente. Il en va de même avec les chariots, qui sont le moyen de transport, et le nombre de mineurs. S’il y a plusieurs chariots à remplir en même temps, la vitesse d’exploitation augmente. Et c’est pareil si plusieurs mineurs sont à l’œuvre.

Un autre élément contribue à accélérer drastiquement la vitesse de traitement: la taille des caches L1 à L3 (mémoire intermédiaire). Dans le cas du travail à la mine, cela correspondrait à des stocks de charbon placés à proximité de notre mineur et de son chariot. Pour notre ouvrier, la méthode s’avère beaucoup plus efficace: il peut transférer le charbon des stocks directement dans le wagon et n’a pas besoin de courir à l’autre bout de la mine pour chaque chargement ni d’extraire le charbon par lui-même. Plus les stocks sont importants, plus les chariots peuvent être remplis rapidement.

Il est possible d’augmenter ainsi le rendement jusqu’à un certain point (vitesse de pelletage, nombre de chariots et d’ouvriers à disposition, largeur des stocks). Toutefois, à un moment donné, un seuil est atteint, car pour des raisons de place, il n’est pas possible de disposer d’un nombre illimité de chariots et de mineurs. Le rythme de travail des mineurs ne peut pas être augmenté à volonté et les stocks ne sont pas non plus infinis.

Cependant, il existe une autre possibilité pour optimiser le tout: augmenter la taille des pelles. Dans notre analogie avec les mines, cela correspond à l’IPC (instructions par cycle) des processeurs modernes. Plus l’IPC est élevé, plus le processeur peut exécuter d’instructions en un cycle d’horloge. Par instructions, on entend des ordres simples tels que «additionner», «comparer» ou «enregistrer une information dans la mémoire vive».

Mais là encore, tout n’est pas si facile: en effet, le talon d’Achille d’une architecture IPC sophistiquée est son optimisation. La plupart du temps, la conception de ces circuits est affûtée pour des applications ou des benchmarks spécifiques. En d’autres termes, l’architecture IPC fonctionne parfaitement pour certains programmes, mais pas très efficacement pour d’autres. Dans le cas de notre mine, cela signifie concrètement que tant que l’on extrait du charbon, le travail à la mine fonctionne comme sur des roulettes. Mais si l’on veut aussi extraire de l’or, de l’argent ou tout autre minerai, l’outil doit répondre à d’autres exigences. L’extraction ralentit, voire s’arrête complètement.

La prédiction de branchement

Pour contrer ce frein, il existe la prédiction de branchement, une autre fonction intelligente au sein du processeur, qui n’a pour d’autre but que de prédire avec précision le résultat de branchement des prochaines instructions et de charger cela dans le cache. L’accès au cache est beaucoup plus rapide que l’accès aux autres types de mémoire. Ainsi, les pipelines mis à disposition pour le traitement des instructions sont utilisés de manière optimale et la vitesse de traitement augmentée.

Dans notre exemple, la prédiction de branchement correspond à un deuxième employé des mines qui essaie de prédire de quoi aura besoin notre premier mineur pour son travail d’après. Il extrait alors cela du sol (mémoire vive) et en remplit aussi la réserve (cache). Par exemple, si le premier mineur demande souvent du charbon et de l’argent, le deuxième mineur extrait ces deux matières du sol et les stocke dans la réserve pour lui. Mais s’il faut soudainement de l’or et qu’il n’y en a pas en réserve, le premier mineur devra l’extraire lui-même, et cela va lui prendre beaucoup plus de temps. Les jeux sur PC, qui dépendent fortement de données d’entrée (imprévisibles), sont un exemple classique de programmes pour lesquels la prédiction de branchement rencontre des difficultés. Mais là encore, de grands progrès ont été faits au cours des dernières années grâce à des algorithmes intelligents de prédiction de branchement.

Les résultats seront d’autant plus précis que le cache dont dispose la prédiction de branchement sera grand. Tout comme les autres composants, le cache prend lui aussi beaucoup de place à l’intérieur du processeur. Par conséquent, les développeurs des processeurs doivent sans cesse faire des compromis.

Jongler est la clé

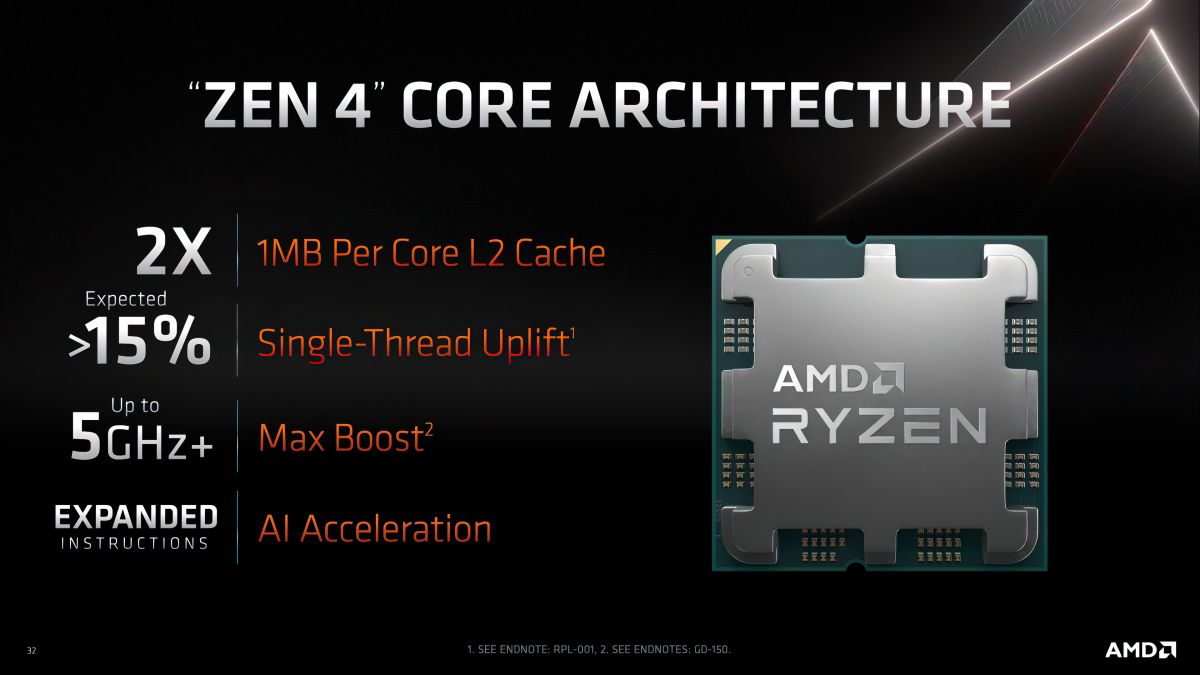

De toute évidence, une fréquence d’horloge aussi élevée que possible ne garantit plus à elle seule la vitesse d’un processeur de pointe. Le nombre de cœurs, le cache et les fonctions spéciales comme l’IPC ou la prédiction de branchement (illustration 4) jouent un rôle tout aussi important.

Les tout derniers processeurs Intel de la douzième et de la treizième génération proposent en outre leurs propres noyaux E à faible consommation d’énergie, ainsi que des noyaux P performants, afin de séparer rigoureusement les tâches non critiques des tâches gourmandes en puissance. Cela permet de réduire la consommation d’énergie, mais surtout de faire moins chauffer le processeur. De ce fait, selon l’application, les processeurs qui ont une fréquence plus faible peuvent finalement effectuer la tâche plus rapidement qu’un processeur doté d’une fréquence plus élevée, mais qui chauffe plus rapidement et doit ralentir.

En quoi les benchmarks sont-ils utiles?

AMD et Intel aiment bien optimiser leurs processeurs au moyen d’IPC sur des benchmarks dits «synthétiques», tels que Cinebench, Geekbench ou PCMark. De tels programmes de test se concentrent généralement sur un composant en particulier (processeur, carte graphique, disque SSD, etc.). Bien souvent, ils ne reflètent donc pas l’expérience des utilisateurs. Les tests en situation réelle permettent d’évaluer les performances du système dans la pratique. Il s’agit ici de tâches telles que la décompression de données, la compression de fichiers ou encore le rendu 3D.

Exemple: un benchmark du monde réel spécialement conçu pour le jeu est une très bonne option pour tester un PC de gaming. Cependant, il ne va pas plus loin. En revanche, si vous souhaitez tester un seul composant, il est recommandé d’utiliser un test synthétique. Pour toutes ces raisons, il est nécessaire de compléter les benchmarks avec des tests indépendants sur les nouveaux processeurs.

Conclusion: l’architecture globale pèse dans la balance

Bien entendu, une fréquence d’horloge aussi élevée que possible joue en faveur des performances. Ainsi, avec la série de processeurs Raptor Lake récemment présentée (fréquence maximale: 5,8 GHz), c’est la première fois qu’Intel visait la fréquence de 6 Ghz (ill. 5). Mais disposer du plus grand nombre de cœurs parallèles possible est tout aussi important, si ce n’est plus. Ils augmentent les performances globales du processeur et veillent notamment à ce que les applications complexes que les programmeurs optimisent pour plusieurs cœurs fonctionnent avec la même fluidité. Seule une interaction optimale entre fréquence, traitement parallèle et pipelines de données bien remplis garantit en bout de course la vitesse adéquate à l’utilisateur. C’est précisément pour cette raison qu’il est important que les mémoires des caches L1, L2 et L3 soient à la bonne taille. En effet, elles veillent à alimenter les noyaux en données de manière suffisamment rapide. Ou, à l’inverse: sans une bonne coordination, ces pipelines s’assèchent. Dans ce cas, même l’unité de calcul la plus rapide n’apporte rien.

En conclusion, s’il fallait retenir une seule chose: outre l’architecture du processeur ou ses caractéristiques techniques, seuls des tests indépendants avec différents benchmarks (sur des jeux vidéos ou la consommation d’énergie par exemple) donnent des informations fondées sur la performance réelle d’un processeur.

Articles associés

Vous trouverez ici d'autres articles passionnants sur ce thème.

Comprendre les noms des processeurs: Intel

Le nom d’un processeur fournit beaucoup d’informations sur les applications pour lesquelles il est conçu, sur son ancienneté et sur ses capacités. Ceci peut se révéler pratique lorsqu’il s’agit de choisir l’ordinateur approprié. Nous vous révélons ci-dessous les secrets qui se cachent derrière les noms des processeurs Intel et comment interpréter ces derniers pour acheter exactement ce dont vous avez besoin.

23.02.2023

Lire plus

Comprendre les noms des processeurs: AMD

Le nom d’un processeur fournit beaucoup d’informations sur les applications pour lesquelles il est conçu, sur son âge et sur ses capacités. Cela peut se révéler pratique comme point de repère initial lors du choix de l’ordinateur approprié. Nous vous expliquons ci-dessous comment sont structurés les noms des processeurs AMD et comment identifier la perle rare en fonction de sa désignation.

22.02.2023

Lire plus