Prozessoren-Vergleich: warum GHz nichts aussagt

Für die Leistung von Prozessoren in Desktop-PCs oder Notebooks ist mittlerweile weit mehr als die reine Gigahertz-Angabe ausschlaggebend. Wir zeigen, welche aktuellen CPU-Bestandteile die Leistung signifikant bestimmen.

Spannende Geschichten beginnen meist in der Vergangenheit. Und gerade bei dem fast schon ewigen Duell zwischen den beiden Prozessorherstellern AMD und Intel lohnt es sich, einen kurzen Blick zurückzuwerfen.

AMD vs. Intel: das ewige Duell

Bis 1998 war die Intel-Welt in Ordnung. Die damalige Vorzeige-Prozessorreihe «Pentium» wurde weltweit in acht von zehn PCs eingesetzt. AMD spielte nahezu keine Rolle in der ersten Liga der Mittel- und High-End-Klasse der PCs. Punkten konnte AMD nur mit dem Preis.

Das Jahr 1999 markierte für AMD dank der neu entwickelten «Athlon»-CPU einen Wendepunkt. Plötzlich hatte man einen Prozessor zur Hand, der den übermächtigen Konkurrenten Intel leistungsseitig in den Schatten stellte. Das überraschte alle: AMD war ein kleines Unternehmen, dessen Jahresumsatz ungefähr dem entsprach, was Intel an Steuern zu zahlen hatte. Dieses Unternehmen entwickelte nun eine CPU, die dem Pentium überlegen war. Der Grund: Die damalige Pentium-Strategie, mit immer höheren Taktraten das Tempo zu steigern, ging nicht mehr auf. Es kam zu immensen Hitzeproblemen der CPU und zu Leistungseinbussen. Die CPU musste die Taktfrequenz senken, um das Durchschmelzen der Schaltkreise zu verhindern (Throttling). Die Folge: AMD jagte Intel immer mehr Marktanteile ab – zumindest bis 2006.

Die Wende mit der Core-Mikroarchitektur

Doch Intel konnte 2006 mithilfe seines israelischen Forschungslabors endlich zurückschlagen. Der dort entwickelte Desktop-Prozessor «Core 2 Duo», der gegen den damaligen Athlon 64 FX-62 antrat, rückte die Dinge für Intel wieder zurecht. Dreh- und Angelpunkt der CPU war die «Core Microarchitecture». Plötzlich war nicht mehr ein möglichst hoher Gigahertz-Takt entscheidend, sondern die Leistung. Diese wurde zudem auf mehrere parallele und (energie-)effizient arbeitende Kerne innerhalb eines Hauptprozessors verteilt. Der damalige Entscheid von Intel: Sämtliche Core-2-Duos und auch die folgenden Prozessorgenerationen für Laptops, Desktop-PCs und sogar Server stammen aus ein und derselben Fertigungslinie, werden aber für die jeweilige Gerätekategorie optimiert. Das beschleunigte die Fertigung und vereinfachte auch das Prozessordesign.

Jetzt war AMD wieder gefordert. Und es dauerte bis 2017, bis AMD endlich richtig mithalten konnte (Bild 1). In diesem Jahr wurde AMDs neue «Zen/Zen+»-Prozessorarchitektur mit dem Markennamen Ryzen (gesprochen «Reisen») eingeführt. Sie bot Intel die Stirn. Das enge Kopf-an-Kopf-Rennen zwischen AMD und Intel dauert seither an. Der Führungsanspruch der beiden Streithähne wechselt bis heute meist mit der jeweils neu vorgestellten «Ryzen»- respektive «Core-i»-Prozessorlinie.

Betrachtet man die Veränderungen der Prozessorarchitektur von damals bis heute, stellt man fest, dass sich die CPUs von recht einfach aufgebauten Einzelkernprozessoren mit immer höheren Taktraten zu Chips mit mehreren, parallelen, energieeffizient arbeitenden Recheneinheiten entwickelt haben. Zudem sorgen die immer kleineren und feineren Strukturbreiten der Leiterbahnen (mittlerweile im einstelligen Nanometer-Bereich; 1 Nanometer = 1*10-9 Meter) für eine Erhöhung der gesamten Komplexität. Diese Komplexität ist neben der CPU-Taktfrequenz und den parallelen Recheneinheiten der dritte wichtige Bestandteil, um die Gesamtleistung des Prozessors einzuordnen.

Warum die reine Taktfrequenz gar nichts aussagt

Wer die Leistung des Prozessors rein auf den Takt reduziert, tut heutigen Prozessoren unrecht. Nur ein Beispiel: Moderne CPUs, egal ob sie von AMD oder Intel hergestellt werden, können mittlerweile ihre Taktraten je nach Applikation variieren. Die Logik innerhalb der CPU erkennt die Anforderungen, die das Spiel oder die App an das Abarbeiten der Befehle stellt.

Prinzipiell stehen nun der CPU gleich zwei richtungsweisende Wege zu Verfügung, um die Befehle schnellstmöglich abzuarbeiten. Entweder kann der Prozessor mehrere Kerne hinzunehmen, um das parallele Abarbeiten zu beschleunigen, oder er reduziert auf wenige oder nur einen Kern. In diesem Fall werden zum Abarbeiten der Aufgabe nicht mehr Kerne benötigt. Dafür kann aber die Taktrate des einen Kerns erhöht werden, wovon wiederum das Tempo profitiert.

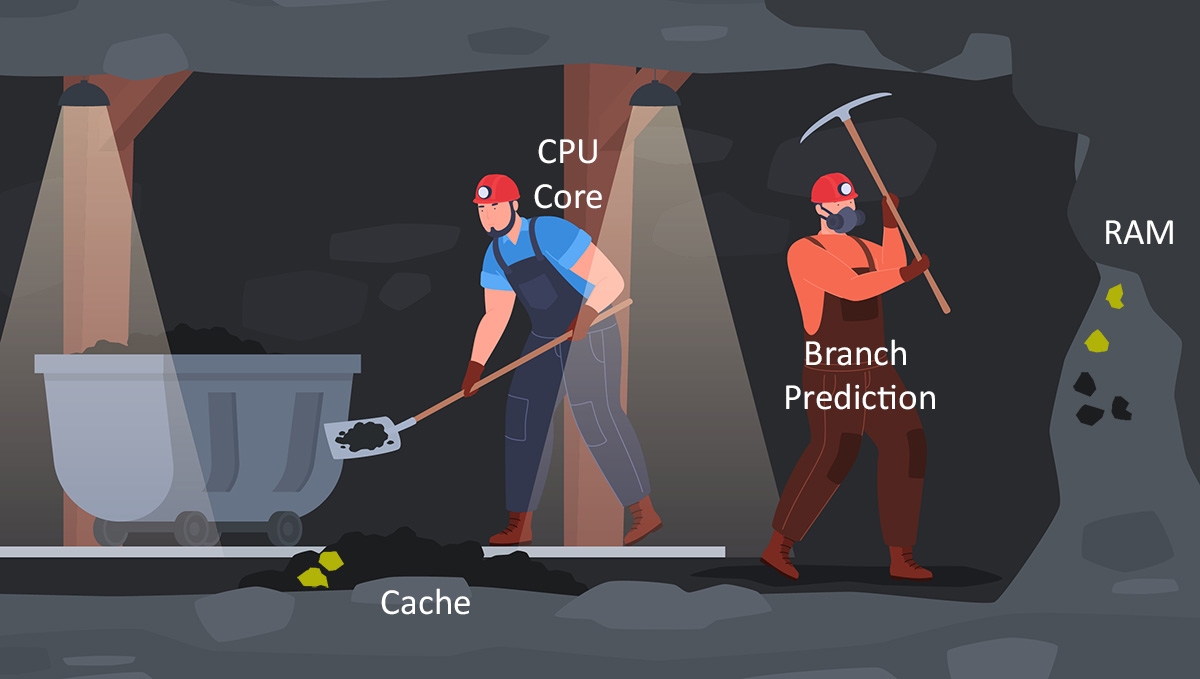

Um dies bildlich zu veranschaulichen, vergleichen wir die Arbeitsweise der CPU mit der Arbeit in einem Bergwerk (Bild 2): Ein Bergwerksmitarbeiter schaufelt Kohle in einen Förderwagen. Der Bergwerksmitarbeiter entspricht einem Prozessorkern, die Kohle den zu verarbeitenden Daten oder Befehlen. Dabei steht die Taktfrequenz für nichts anderes als das Tempo, mit dem der Bergwerksarbeiter seine Schaufel bewegt, um den Förderwagen zu befüllen. Der Förderwagen entspricht in unserem Bild den Leiterbahnen für den Datentransport. Die Anzahl Prozessorkerne könnte man mit der Anzahl der Arbeiter gleichsetzen.

Wird der Wagen schneller befüllt (mehr Tempo = mehr GHz), steigert das den Output. Genauso verhält es sich auch mit den Förderwagen, also dem Transportmedium, sowie mit der Anzahl an Arbeitern. Stehen mehrere Wagen parallel zum Füllen bereit, erhöht sich das Betriebstempo. Dasselbe gilt, wenn mehr Arbeiter am Werk sind.

Und noch etwas kann die Verarbeitungsgeschwindigkeit massiv beschleunigen: die Grösse des L1- bis L3-Cache (Zwischenspeicher). Beim Bergwerk würde dies einem Kohle-Vorratslager entsprechen, welches näher an unserem Bergwerksmitarbeiter und seinem Förderwagen liegt. Für unseren Arbeiter ist das viel effizienter: Er kann die Kohle direkt vom Vorratslager in den Förderwagen befördern und muss nicht für jede Ladung Kohle zum Ende der Mine laufen und sie selbst aus dem Boden schaufeln. Je grösser die Lager sind, desto schneller können die Wagen befüllt werden.

Der Output lässt sich in allen Fällen (Schaufeltempo, Anzahl bereitstehender Wagen und Arbeiter, Lagergrösse) bis zu einem gewissen Mass steigern. Irgendwann ist aber Schluss, da aus Platzgründen nicht beliebig viele Wagen und Arbeiter zur Verfügung stehen. Das Arbeitstempo der Minenarbeiter kann ebenfalls nicht beliebig in die Höhe getrieben werden und die Vorratslager sind auch nicht unendlich gross.

Doch es gibt eine weitere Möglichkeit, mehr herauszuholen: grössere Schaufeln. Dies entspricht in unserer Bergwerksanalogie dem IPC (Instructions Per Cycle, Anweisungen pro Zyklus) bei modernen Prozessoren. Ist der IPC-Wert grösser, können in einem Taktzyklus mehr Instruktionen abgearbeitet werden. Unter Instruktionen versteht man einfache Befehle wie «Addieren», «Vergleichen» oder «Speichere eine Information auf dem Arbeitsspeicher».

Aber auch das ist nicht so einfach: Das Problem an einer ausgefeilten IPC-Architektur ist nämlich ihre Optimierung. Meist ist das Design solcher Schaltkreise auf spezielle Apps oder Benchmarks hin geschärft. Das heisst, die IPC-Architektur arbeitet für manche Programme hervorragend, für andere wiederum nicht sehr effizient. In unserem Beispiel des Bergwerks bedeutet dies konkret: Solange unter Tage Kohle abgebaut wird, läuft die Mine wie geschmiert. Wenn nun aber auch Gold, Silber oder ein anderer Rohstoff gewonnen werden soll, sind andere Voraussetzungen ans Werkzeug gefragt. Der Abbau verlangsamt sich oder kommt sogar ganz zum Stehen.

Die Branch Prediction

Um dieser Bremse entgegenzuwirken, gibt es die Branch Prediction (Verzweigungsvorhersage), eine weitere clevere Funktion innerhalb der CPU. Sie macht nichts anderes, als eine möglichst genaue Verzweigungsvorhersage für anstehende Anweisungen zu treffen und diese in den Cache zu laden. Der Zugriff auf den Cache ist sehr viel schneller als der auf andere Speichertypen. So werden die zur Verfügung stehenden Pipelines zur Befehlsverarbeitung optimal ausgelastet und die Verarbeitungsgeschwindigkeit erhöht.

In unserem Beispiel entspricht die Branch Prediction einem zweiten Bergwerksmitarbeiter, der versucht vorherzusagen, welche Ressourcen unser erster Bergwerksmitarbeiter als Nächstes benötigt. Diese gräbt er schonmal aus dem Boden (Arbeitsspeicher) und befüllt damit das Vorratslager (Cache). Wenn der erste Bergwerksmitarbeiter beispielsweise oft nach Kohle und Silber verlangt, gräbt der zweite Arbeiter diese beiden Rohstoffe aus dem Boden und legt sie im Vorratslager für den ersten Arbeiter ab. Wird aber plötzlich Gold benötigt und im Vorratslager liegt keines bereit, muss unser erster Bergwerksmitarbeiter selbst Gold aus dem Boden buddeln, was viel länger dauert. Klassisches Beispiel für Programme, bei denen die Branch Prediction ihre Schwierigkeiten hat, sind Computerspiele, die stark von (unvorhersehbaren) Input-Daten abhängen. Aber auch hier wurden durch clevere Branch-Prediction-Algorithmen in den letzten Jahren grosse Fortschritte gemacht.

Die Treffergenauigkeit erhöht sich, wenn der Branch Prediction ein möglichst grosser Cache zur Verfügung steht. Dieser wiederum benötigt viel Platz innerhalb der CPU – genau wie alle anderen Bestandteile des Prozessors. Folglich müssen CPU-Entwickler immer einen Kompromiss eingehen.

Die Mischung machts

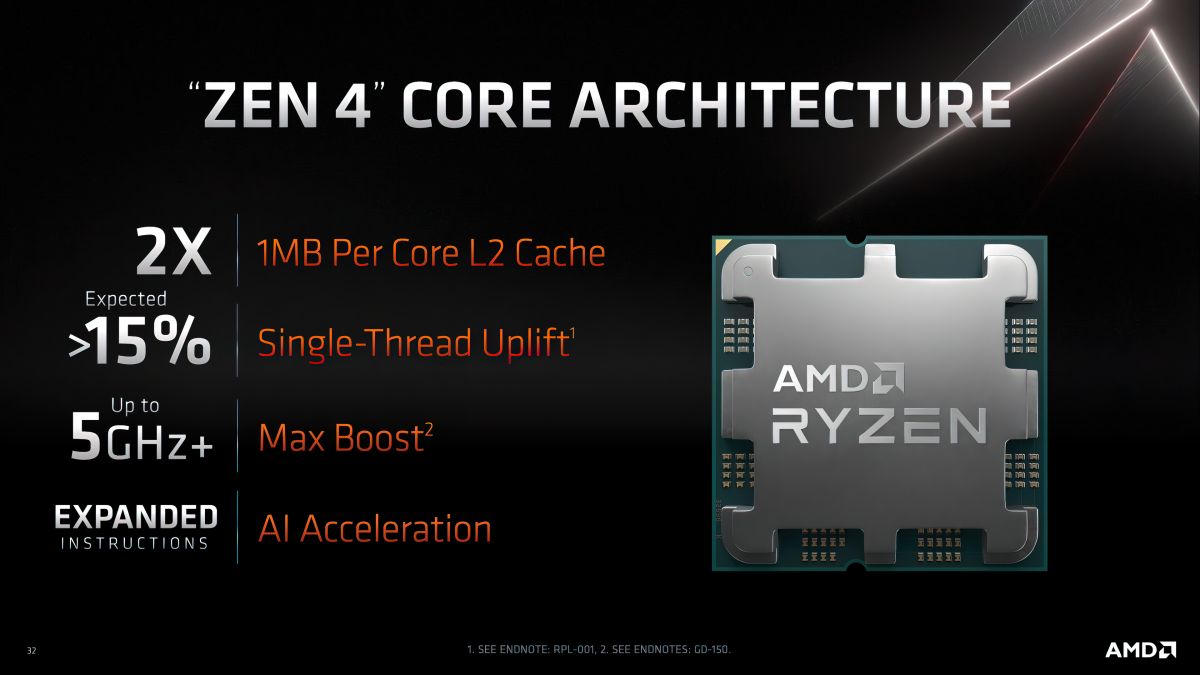

Damit wird klar, dass eine möglichst hohe Taktrate allein kein hundertprozentiger Garant für eine schnelle High-End-CPU ist. Genauso wichtig sind die Anzahl Kerne, der Cache und Sonderfunktionen wie IPC und Branch Prediction (Bild 4).

Intels neuste Prozessoren der zwölften und dreizehnten Generation bieten zudem eigene energieeffiziente E-Kerne wie auch performante P-Kerne an, um unkritische von leistungshungrigen Aufgaben rigoros zu trennen. Das reduziert den Strombedarf, heizt vor allem aber den gesamten Prozessor weniger auf. Dadurch können CPUs, die eine kleinere Taktrate haben, letztlich je nach Anwendung die Aufgabe schneller erledigen als ein höher getakteter Prozessor, der sich schneller aufheizt und ausbremsen muss.

Wie helfen Benchmarks?

AMD und Intel optimieren ihre Prozessoren mittels IPC gerne auf sogenannte synthetische Benchmarks wie Cinebench, Geekbench oder PCMark. Solche Testprogramme fokussieren sich meist auf einzelne Komponenten (Prozessor, Grafikkarte, SSD-Datenträger etc.) und spiegeln deshalb oft nicht die tatsächlichen Erfahrungswerte der Nutzer wider. Die praxisnahe System-Performance adressieren Real-World-Tests. Hier sind Aufgaben wie das Entpacken von Dateien oder auch die Dateikompression respektive das 3D-Rendering zu nennen.

Ein Beispiel: Ein Real-World-Benchmark, der speziell fürs Gaming entwickelt wurde, ist eine sehr gute Option zum Testen eines Gaming-PCs – mehr aber auch nicht. Wollen Sie hingegen eine einzelne Komponente testen, empfiehlt sich ein synthetischer Test. Schon deshalb gibt es folglich genug Gründe, weshalb es zusätzlich zu den Benchmarks unabhängige Tests für neue CPUs braucht.

Fazit: Die Gesamtarchitektur ist wichtig

Natürlich tut der Performance eine möglichst hohe Taktrate gut. So nimmt Intel mit der jüngst vorgestellten Raptor-Lake-Serie (maximaler Takt: 5,8 GHz) erstmals die 6-GHz-CPU-Taktrate ins Visier (Bild 5). Mindestens genauso wichtig sind aber auch möglichst viele parallele Kerne. Sie heben die Gesamtleistung der CPU und sorgen unter anderem dafür, dass komplexe Anwendungen, die Programmierer für mehrere CPU-Kerne optimieren, ebenso flüssig laufen. Nur ein optimales Zusammenspiel zwischen Takt, paralleler Verarbeitung und gefüllten Daten-Pipelines sorgt im Endeffekt auch für Tempo, das beim Nutzer ankommt. Gerade deshalb sind richtig dimensionierte Speichergrössen des L1-, L2- und L3-Caches wichtig. Denn sie sorgen dafür, dass die Kerne schnell genug mit Daten gefüttert werden. Oder andersherum: Ohne die richtige Koordination trocknen diese Pipelines aus. Dann bringt auch die schnellste Recheneinheit nichts.

Die wichtigste Erkenntnis liegt allerdings ausserhalb einer jeden Prozessorarchitektur respektive seiner technischen Merkmale: Nur unabhängige Tests mit verschiedenen Benchmarks, sei es für Games oder zu Energiemessungen, geben fundierten Aufschluss über die tatsächliche Prozessorleistung.

PC-Komponenten & Peripherie

Weitere Ratgeber entdecken

PCs, Laptops & Zubehör

Weitere Ratgeber entdeckenVerwandte Beiträge

Hier finden Sie weitere spannende Beiträge zum Thema.

Prozessornamen verstehen: Intel

Der Name eines Prozessors gibt Ihnen viele Infos darüber, wofür er gedacht ist, seit wann es ihn gibt und was er sonst noch kann. Das ist praktisch als Entscheidungshilfe bei der Wahl des passenden Rechners. Im Folgenden erklären wir Ihnen die Namen von Intel-Prozessoren und wie Sie diese "lesen müssen", um genau das zu kaufen, was Sie wirklich brauchen.

23.02.2023

Mehr lesen

Prozessornamen verstehen: AMD

Der Name eines Prozessors gibt Ihnen viel Auskunft darüber, für welche Anwendungen er gemacht ist, wie alt er ist und was er sonst noch kann. Das ist praktisch als erster Anhaltspunkt bei der Wahl des passenden Rechners. Hier erklären wir Ihnen, wie die Namen von AMD-Prozessoren aufgebaut sind und wie Sie anhand des Prozessornamens erkennen, welchen Sie wirklich benötigen.

22.02.2023

Mehr lesenKommentare (0)

Bitte melden Sie sich an, um die Kommentarfunktion zu nutzen.